本博客根据机器学习实战这本书,主要是对机器学习的算法原理及Python完成进行详细解说,若是有些没有论述清楚的,看到的请指出。

第二章的K近邻算法是一个简略的机器学习算法。

K近邻算法:

原理:搜集一个样本数据调集,而且样本会集每个数据都存在标签。输入没有标签的新数据后,将新数据的每个特征与样本会集数据对应的特征进行比较,然后算法提取样本会集特征最类似数据(最近邻)的分类标签。挑选样本数据会集前K个最类似的数据,这便是K近邻算法中K的出处,一般k是不大于20的整数。挑选k个最类似数据中呈现次数最多的分类,作为新数据的分类。

算法完成:新建一个kNN.py文件

1. 导入数据

#-*- coding: utf-8 -*- #表明运用这个编码

from numpy import * #导入科学核算包NumPy,没装置赶忙百度装置

import operator #运算符模块,k近邻算法履行排序操作时将运用这个模块供给的函数

import pdb #在Python交互环境中启用调试

from os import listdir # os 模块包含了许多对目录操作的函数 listdir 函数回来给定目录下的一切文件

def createDataSet():#界说一个函数,创立数据集和标签

group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])

labels = [‘A’,’A’,’B’,’B’]

return group,labels

保存后import kNN

group,labels = kNN.createDataSet(),然后就能够得到group,labels

详细的kNN算法:

思维:核算已知类别数据会集的点和当时点之间的间隔;

依照间隔递加次第排序;

选取与当时点间隔最小的k个点;

确认前k个点地点类别的呈现频率;

回来前k个点呈现频率最高的类别作为当时点的猜测分类。

def classify0(inX,dataSet,labels,k):#inX是测验向量,dataSet是样本向量,labels是样本标签向量,k用于挑选最近街坊的数目

dataSetSize = dataSet.shape[0] #得到数组的行数。即知道有几个练习数据,0是行,1是列

diffMat = tile(inX,(dataSetSize,1)) – dataSet #tile将本来的一个数组,扩大成了dataSetSize个相同的数组。diffMat得到了方针与练习数值之间的差值。

sqDiffMat = diffMat**2 #各个元素别离平方

sqDistances = sqDiffMat.sum(axis=1) #便是一行中的元素相加

distances = sqDistances**0.5#开平方,以上是求出测验向量到样本向量每一行向量的间隔

sortedDistIndicies = distances.argsort()#对间隔进行排序,从小到大

classCount={}#结构一个字典,针对前k个近邻的标签进行分类计数。

for i in range(k):

voteIlabel = labels[sortedDistIndicies[i]]

classCount[voteIlabel] = classCount.get(voteIlabel,0)+1#得到间隔最小的前k个点的分类标签

sortedClassCount = sorted(classCount.iteritems(),key = operator.itemgetter(1),reverse = True)#对classCount字典分化为元素列表,运用itemgetter办法依照第二个元素的次第对元组进行排序,回来频率最高的元素标签,计数前k个标签的分类,回来频率最高的那个标签

return sortedClassCount[0][0]

这样就能够运用该程序进行数据猜测了。

kNN.classify0([0,0],group,labels,3)输出成果为B。

测验kNN算法

这个测验是作者供给的文本文件,先解析文本,画二维分散图,kNN不必进行练习,直接调用文本数据核算k近邻就能够。

将文本记载转换为NumPy的解析程序

def file2matrix(filename):#将文本记载转换成numpy的解析程序

fr = open(filename) #这是python翻开文件的方法

arrayOLines = fr.readlines()#主动将文件内容分析成一个行的列表

numberOfLines = len(arrayOLines)#得到文件的行数

returnMat = zeros((numberOfLines,3))

classLabelVector = []

enumLabelVector = []

index = 0

for line in arrayOLines:

line = line.strip()#截掉一切的回车符

listFromLine = line.split(‘t’)#运用tab字符t将上一步得到的整行数据分割成元素列表

returnMat[index,:] = listFromLine[0:3]#选取前三个元素存储到特征矩阵中

classLabelVector.append(listFromLine[-1])#用-1表明最终一列元素,把标签放入这个向量中

if cmp(listFromLine[-1],’didntLike’)==0:

enumLabelVector.append(1)

elif cmp(listFromLine[-1],’smallDoses’)==0:

enumLabelVector.append(2)

elif cmp(listFromLine[-1],’largeDoses’)==0:

enumLabelVector.append(3)

index += 1

return returnMat,enumLabelVector #回来数据矩阵和标签向量

能够运用reload(kNN)

datingDataMat,datingLabels = kNN.file2matrix(‘datingTestSet.txt’)得到数据矩阵和标签向量。

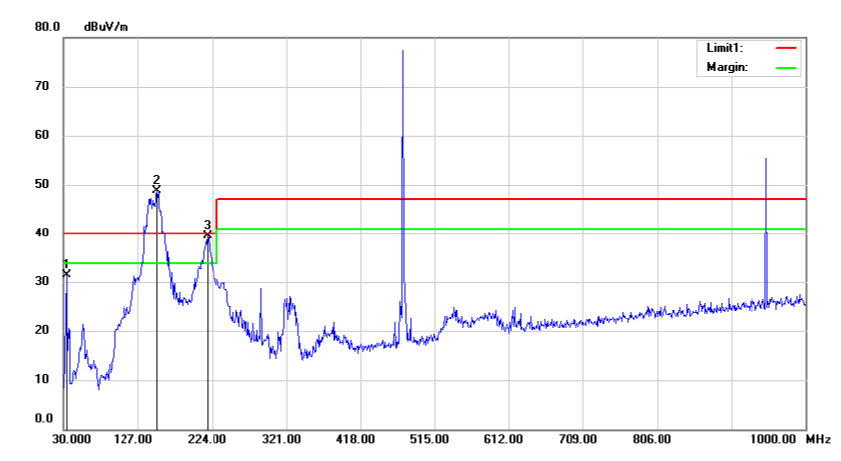

运用Matplotlib制造原始数据的散点图

fig = plt.figure()

ax = fig.add_subplot(131)

ax.scatter(datingDataMat[:,1],datingDataMat[:,2])

ax = fig.add_subplot(132)

ax.scatter(datingDataMat[:,1],datingDataMat[:,2],15.0*array(vector),15.0*array(vector))

ax = fig.add_subplot(133)

ax.scatter(datingDataMat[:,0],datingDataMat[:,1],15.0*array(vector),15.0*array(vector))

plt.show()

在核算KNN间隔时,若某一列的数值远大于其他列, 那这一列对核算间隔时的影响最大。将数据归一化,每一列的数据取值规模处理为0-1之间,这样每一列的数据对成果影响都相同。

归一化特征值:

def autoNorm(dataSet):

minVals = dataSet.min(0)#取得最小值,(0)是从列中获取最小值,而不是当时行,便是每列都取一个最小值

maxVals = dataSet.max(0)#取得最大值

ranges = maxVals – minVals#取得取值规模

normDataSet = zeros(shape(dataSet))#初始化新矩阵

m = dataSet.shape[0]#取得列的长度

normDataSet = dataSet – tile(minVals,(m,1))#特征值是1000×3,而最小值和规模都是1×3,用tile函数将变量内容复制成输入矩阵相同巨细的矩阵

normDataSet = normDataSet/tile(ranges,(m,1))#/可能是除法,在numpy中,矩阵除法要用linalg.solve(matA,matB).

return normDataSet,ranges,minVals

将数据集分为测验数据和样本数据

def datingClassTest():

hoRatio = 0.10

datingDataMat,datingLabels = file2matrix(‘datingTestSet.txt’)#读取文件中的数据并归一化

normMat,ranges,minVals = autoNorm(datingDataMat)

m = normMat.shape[0]#新矩阵列的长度

numTestVecs = int(m*hoRatio)#代表样本中哪些数据用于测验

errorCount = 0.0#错误率

for i in range(numTestVecs):

classifierResult = classify0(normMat[i,:],normMat[numTestVecs:m,:],datingLabels[numTestVecs:m],3)#前m×hoRatio个数据是测验的,后边的是样本

print the calssifier came back with: %d,the real answer is:%d %(classifierResult,datingLabels[i])

if(classifierResult != datingLabels[i]):

errorCount += 1.0

print the total error rate is: %f %(errorCount/float(numTestVecs))#最终打印出测验错误率

构建猜测函数,输入信息得到猜测标签

#输入或人的信息,便得出对对方喜爱程度的猜测值

def classifyPerson():

resultList = [‘not at all’, ‘in small doses’, ‘in large doses’]

percentTats = float(raw_input(percentage of time spent playing video games?))#输入

ffMiles = float(raw_input(frequent flier miles earned per year?))

iceCream = float(raw_input(liters of ice cream consumed per year?))

datingDataMat, datingLabels = file2matrix(‘datingTestSet.txt’) #读入样本文件,其实不算是样本,是一个标准文件

normMat, ranges, minVals = autoNorm(datingDataMat)#归一化

inArr = array([ffMiles, percentTats, iceCream])#组成测验向量

# pdb.set_trace()#可debug

classifierResult = classify0((inArr-minVals)/ranges, normMat, datingLabels,3)#进行分类

# return test_vec_g,normMat,datingLabels

print ‘You will probably like this person:’, resultList[classifierResult – 1]#打印成果

在python下输入kNN.classifyPerson(),输入或人的信息,就能够得到该人的标签。

8.手写辨认系统的示例:

搜集数据时,要将手写的字符图画转换成向量。

def img2vector(filename):

returnVect = zeros((1,1024))#初始化一个向量

fr = open(filename)#翻开文件

for i in range(32):

lineStr = fr.readline()#读入每行向量

for j in range(32):

returnVect[0,32*i+j] = int(lineStr[j])#把每行的向量别离赋值给初始化向量

return returnVect#回来向量

将数据处理成分类器能够辨认的格局后,将这些数据输入到分类器,检测分类器的履行作用。

def handwritingClassTest():

hwLabels = []

trainingFileList = listdir(‘trainingDigits’)# 得到目录下一切文件的文件名

m = len(trainingFileList)#得到目录下文件个数

trainingMat = zeros((m,1024))

for i in range(m):

fileNameStr = trainingFileList[i]#对文件名进行分化能够得到文件指的数字

fileStr = fileNameStr.split(‘.’)[0]

classNumStr = int(fileStr.split(‘_’)[0])

hwLabels.append(classNumStr)#把标签添加进list

trainingMat[i,:] = img2vector(‘trainingDigits/%s’ %fileNameStr)#把一切文件都放在一个矩阵里边

testFileList = listdir(‘testDigits’)

errorCount = 0.0

mTest = len(testFileList)

for i in range(mTest):

fileNameStr = testFileList[i]

fileStr = fileNameStr.split(‘.’)[0]

classNumStr = int(fileStr.split(‘_’)[0])

vectorUnderTest = img2vector(‘testDigits/%s’ %fileNameStr)#得到一个向量

classifierResult = classify0(vectorUnderTest,trainingMat,hwLabels,3)#对向量进行k近邻测验

print the classifier came back with: %d the real answer is %d %(classifierResult,classNumStr)

if(classifierResult != classNumStr):errorCount += 1.0

print nthe total number of errors is: %d %errorCount#得到错误率

print nthe total error rate is: %f %(errorCount/float(mTest))

运用kNN.handwritingClassTest()测验该函数的输出成果,顺次测验每个文件,输出成果,核算错误率,由于分类算法不是肯定的,仅仅一个概率问题,所以对每一组数据都有错误率。

至此,第二章根本论述结束,k近邻算法是分类数据最简略有用的算法,运用算法时,咱们有必要有挨近实践数据的练习样本数据。k近邻算法有必要保存悉数数据集,假如练习数据集很大的话,有必要运用很多的存储空间。

长处:精度高,对异常值不灵敏,无数据输入假定

缺陷:nisan复杂度高,空间复杂度高。

适用数据规模:数值型和标称型。