当时,AI由于其CNN(卷积神经网络)算法超卓的表现在图像识别范畴占有无足轻重的位置。根本的CNN算法需求很多的核算和数据重用,十分合适运用FPGA来完结。上个月,Ralph Wittig(Xilinx CTO Office的杰出工程师)在2016年OpenPower峰会上宣布了约20分钟时长的讲演并评论了包含清华大学在内的我国各大学研讨CNN的一些效果。

在这项研讨中呈现了一些和CNN算法完结能耗相关的几个风趣的定论:

①限制运用片上Memory;

②运用更小的乘法器;

③进行定点匹配:相对于32位定点或浮点核算,将定点核算成果精度降为16位。假如运用动态量化,8位核算相同能够发生很好的成果。

在讲演中Wittig还提到了CNN相关的两款产品:CAPI-compatible Alpha DataADM-PCIE-8K5 PCIe加快卡和Auviz Systems供给的AuvizDNN(深度神经网络)开发库。

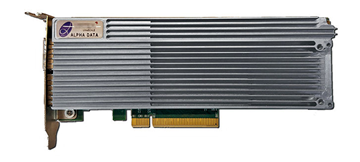

ADM-PCIE-8K5 PCIe加快卡

Alpha DataADM-PCIE-8K5 PCIe加快卡用于X86和IBM Power8/9数据中心和云服务,加快卡根据Xilinx Kintex UltraScale KU115 FPGA,支撑Xilinx SDAcess根据OpenCL、C/C++的开发和根据Vivado HLx的HDL、HLS规划流程。

图1 Alpha DataADM-PCIE-8K5 PCIe加快卡

Alpha DataADM-PCIE-8K5 PCIe加快卡片上带32GB DDR4-2400内存(其间16GB含ECC),双通道SFP+支撑双通道10G以太网接入。供给包含高性能PCIe/DMA在内的板级支撑包(BSP) 、OpenPOWER架构的CAPI、FPGA参阅规划、即插即用的O/S驱动和成熟的API等规划资源。

AuvizDNN开发库

深度学习技能运用很多的已知数据来找出一组权重和偏置值来匹配预期成果。处理被称之为练习,练习的成果是很多的模型,这一现实促进工程师们寻求运用GPU之类的专用硬件来进行练习和分类核算。

跟着未来数据量的巨幅添加,机器学习将会搬到云端完结。这样就急需一种既能够加快算法,又不会大规模添加功耗的处理渠道,在这种情况下,FPGA开端上台。

跟着一些列的先进开发环境投入运用,软件开发工程师将他们的规划在Xilinx FPGA上完结变得愈加简单。Auviz Systems开发的AuvizDNN库为用户供给优化的函数接口,用户能够针对不同的使用创立自定义的CNN。这些函数能够便利的经过Xilinx SDAcess这样的集成开发环境调用。在创立目标和数据池后,就会调用函数创立每一个卷积层、然后是细密层,最终是 softmax层,如下图2所示。

图2 完结CNN的函数调用次序