到现在为止,PCI Express(PCIe)和以太网之间的边界爱憎分明:PCIe用于芯片与芯片间互连;以太网作为一种体系与体系之间的衔接技能。有很好的理由可以阐明为什么该边界可以持久保持。无论如何,这两种技能一向是肯定共存的。尽管没有痕迹标明这一局面会彻底改变,但越来越多的景象显现,在曩昔以太网独大的范畴,PCIe正越来越多地显山露水,特别是在机架内。PCIe真的在同以太网竞赛并能胜出吗?

当时的架构

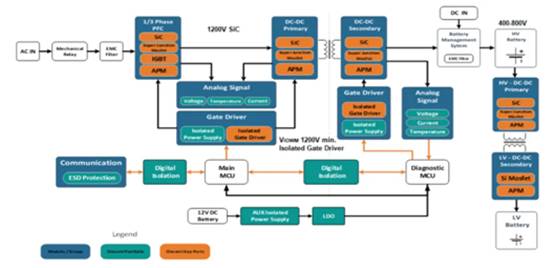

现在批量布置的传统体系具有需求被支撑的多种互连技能。如图1所示,光纤通道和以太网是这些互连的两个比如(明显有更多种技能——如InfiniBand)。

图1:现在运用的传统I/O体系示例。

这种架构有如下约束:

* 多种I/O互连技能共存

* 输入/输出端点运用率低

* 由于需求多个I/O端点,使体系的功耗和本钱都增高

* 在建构体系架构时,I/O就固定了,灵敏性差

* 管理软件有必要处理多个I/O协议,需占用处理才能

这种架构的丧命缺点便是运用了多种I/O互连技能,由于这添加了推迟时刻、加大了本钱、电路板所占空间和功耗。假如一切端点在这段时刻都100%地作业,则这种架构会比较有用。可是,更多的状况是,端点常常是闲暇的,这意味着体系用户要为这有限的运用率掏腰包。添加的推迟是由于这些体系内处理器上本带的PCIe接口要被转换成多种协议。(规划师可以运用处理器自带的PCIe,并交融运用PCIe的一切端点来缩短体系推迟。)

明显,同享I/O端点(见图2)是处理这些约束的有用办法。该概念对体系规划师极具吸引力,由于它降低了本钱和功耗、进步了功用和运用率、并简化了规划。由于同享端点有如此多的优势,所以多个安排都在企图这么做,如PCI-SIG宣布了多条I/O虚拟化(Multi-Root I/O Virtualization——MR-IOV)标准来完结这一方针。可是,由于技能和商业要素的归纳原因,即便MR-IOV已发布五年多,但作为标准一向没被遍及承受。

图2:将PCI Express用于同享I/O的一种传统I/O体系

同享I/O的其它长处有:

* 跟着I/O速度的进步,仅有需求的额定出资是替换I/O适配器卡。在前期布置中,当在同一张卡上运用多种I/O技能时,规划师将不得不从头规划整个体系,而在同享I/O形式,当需求晋级一种特定I/O技能时,规划师可以简略地用新卡替旧卡。

* 由于多个I/O端点不需求存在于同一块卡上,规划师或是可以制作更小的卡,以进一步降低本钱和功耗;或是保存现有的巨细,运用拿去卡上多个I/O端点所省出的空间,经过添加多个CPU、加大内存和/或添加其它端点的办法来差异化其产品。

* 规划师可以削减体系内犬牙交错的电缆的数量。由于多个互连技能会需求不同的电缆,以支撑协议的带宽和开支。可是,跟着规划的简化以及有限的I/O互连技能品种,体系正常作业所需的电缆数量也在削减,然后降低了规划复杂性、节约了本钱。

在PCIe交流机内完结同享I/O是完结如图2所述架构的要害推动者。如前述,MR-IOV技能并没被遍及承受,一种遍及观点是,它或许永久也不会。为此。单根I/O虚拟化(SR-IOV)技能进场救援,为进步功用,它用硬件完结了I/O虚拟化,并在一台物理服务器上供给了根据硬件的安全和质量服务(QoS)特性。SR-IOV还答应在同一台服务器上运转的多个客户操作体系同享I/O设备。

2007年,PCI-SIG发布了SR-IOV标准,以吁求将单一物理PCIe设备划分红多个虚拟功用,无论是网络接口卡、主机总线适配器、仍是主机信道适配器。然后,虚拟机可以运用任一虚拟功用,答应许多虚拟机及其客户操作体系同享一台物理设备。

这需求I/O厂商开发支撑SR-IOV的设备。而SR-IOV供给了在不同运用间,同享资源和I/O设备的最简略办法。现在的趋势是,大部分终端厂商都支撑SR-IOV,而越来越多的厂商将参加这一阵营。

前面已列举了PCIe的许多优点,如虎添翼的是:在传输层,PCIe是种无损建构。

PCIe标准界说了一种健旺的流操控机制,以避免数据包丢掉。在每一“跳”,会对每个PCIe数据进行承认,保证了传输成功。在传输过错的状况下,该包被从头传输——该进程由硬件完结,无需上层协议的任何介入。因而,在根据PCIe的存储体系中,几乎不或许发生数据丢掉和损坏。

经过答应一切的I/O适配器(万兆以太网、FC或其他)移出服务器,PCIe供给了一个简化计划。凭借PCIe交流机架构供给的虚拟化支撑,每个适配器都可以被多个服务器同享,且一起为各服务器供给了一个逻辑适配器。服务器(或每个服务器上的虚拟机)可持续在同享适配器上直接拜访自己的硬件资源集。完结的这种虚拟化答应更好的可扩展性,其间I/O和服务器可以互相独登时进行调适。I/O虚拟化避免了服务器或I/O资源的过度装备,然后降低了本钱和功耗。

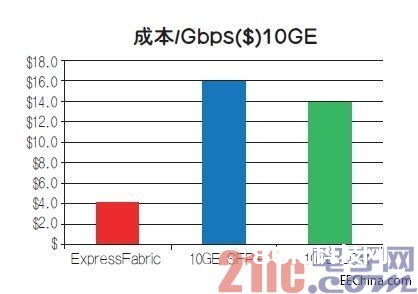

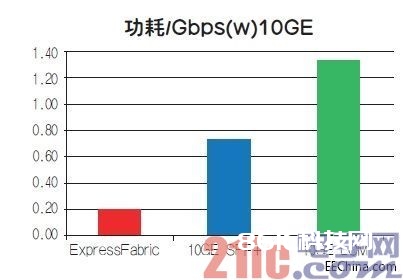

表1供给了PCIe和10G以太网的高层次本钱比较概览;表2供给了两者的高层次功耗比较概览。

表1:PCIe和以太网所节约本钱的比较

表2:PCIe和以太网的降耗比照。

价格预算根据广泛的职业查询,对ToR(top-of-rack)交流机和适配器来说,还假定其价格会因批量、可用性和与供货商的联系深浅有所不同。这两个表为了解将PCIe用于IO同享(特别是经过拿掉了适配器)所带来的本钱和功耗方面的优点供给了结构。

当然,这引发出这样一个疑问:比较本钱和功耗为什么按每秒千兆字节核算,而不以每个端口为根据?首要原因是:眼下,对数据中心供货商来说,其收费趋势是依照所用带宽而不是衔接数来核算。PCIe供给的带宽约是10G以太网的3倍,并答应供货商用它获利更多,若有人曾做过比较(用相同多的端口数建构相同的体系),会得出相同定论:PCIe会比以太网省50%以上。

总结

本文的重点是PCIe和以太网在本钱和功耗方面的比较,当然,也应在两者间比较其他技能指标。可是,跟着首要处理器供货商越来越多地在其处理器上内置PCIe,这让规划师从中收获颇丰。凭借此新一代CPU,规划师可以直接将PCIe交流器与CPU衔接,然后降低了推迟和元件本钱。

PCIe技能已变得无处不在,该强壮互连技能的第3代代表(每链路8Gbps)不仅仅可以支撑同享I/O和集群,还为体系规划师供给了一款无与伦比的东西,以使他们的规划优化、高效。

为满意同享IO和集群细分商场的需求,如PLX Technology等厂商在向商场推出高功用、灵敏、低功耗、体积小的设备。这些交流机被雕刻为可习惯上面说到的全方位运用。展望未来,速度可达每链路16Gbps的第四代PCIe只会有助于加速PCIe技能进入新的细分商场并扩展这些商场,一起用其进行规划和运用也会更简单和经济。

多家全球厂商现已采用了这种无处不在的互联技能以支撑I/O端点同享,因而,降低了体系本钱和功耗要求,减小了保护和晋级需求。根据PCI的同享I/O端点有望使价值数十亿美元的数据中心商场面貌一新。